Umělá inteligence v posledních letech zásadně proměnila způsob, jakým komunikujeme, hledáme informace i řídíme provoz. Spolu s tím ale narostla i technická náročnost. Výpočetně náročné jazykové modely jako GPT nebo Llama běžně potřebují silné grafické procesory a výkonná datová centra. Společnost Groq však přišla s jiným řešením: vytvořila vlastní procesor navržený přímo pro práci s jazykem.

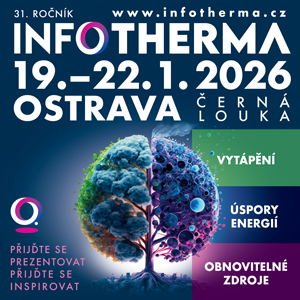

Takzvaná Language Processing Unit (LPU) není jen další výkonný čip. Je to zcela nová architektura postavená na potřebách inferencí – tedy okamžitého generování výstupů z již natrénovaných modelů. A funguje překvapivě dobře.

Proč LPU a proč teď?

Zatímco GPU jsou univerzální výpočetní jednotky určené pro paralelní práci, LPU byla od začátku navržena výhradně pro sekvenční zpracování jazykových dat. Právě tam dochází při práci s LLM modely k největším zpožděním a energetickým ztrátám.

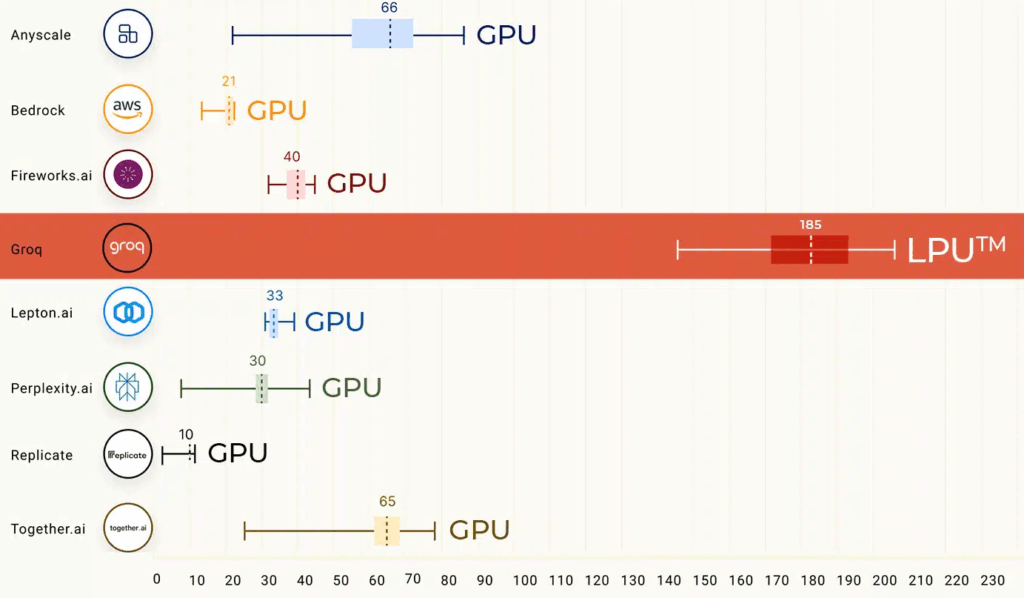

Groq se zaměřil na dvě oblasti, kde běžné systémy často selhávají: rychlost přenosu dat mezi pamětí a výpočetní jednotkou a schopnost zpracovávat výstup po jednotlivých tokenech bez zbytečných záseků. Výsledkem je čip, který dosahuje více než 100 tokenů za sekundu u modelu Llama-2 s 70 miliardami parametrů. To je několikanásobně vyšší rychlost, než jakou zvládají běžné systémy založené na GPU.

Výhody, které jsou vidět i slyšet

Nejde ale jen o rychlost. LPU přináší několik dalších zásadních výhod, které se projevují přímo v praxi:

- Téměř nulová latence znamená, že systém začne odpovídat prakticky okamžitě

- Deterministický výkon přináší předvídatelnost a stabilitu i při složitých úlohách

- Výrazně nižší spotřeba energie pomáhá snižovat provozní náklady a zároveň i uhlíkovou stopu

- Optimalizace přes software umožňuje další ladění bez nutnosti měnit hardware

To vše dělá z LPU zajímavou volbu pro aplikace, které musí pracovat rychle a spolehlivě – od chatbotů a překladačů až po analytické nástroje a řízení v reálném čase.

Co LPU nedělá

Je důležité zdůraznit, že LPU není náhradou za trénovací infrastrukturu. Není určena pro výuku nových modelů, ale pro jejich nasazení. To znamená, že vývoj a doladění zůstává doménou velkých GPU clusterů nebo specializovaných systémů. Groq se tak cíleně zaměřuje na segment, kde je výkon a odezva důležitější než flexibilita trénování.

Jaké jsou možnosti nasazení?

Technologie Groq zatím není na trhu masově rozšířená, ale začínají ji testovat firmy, které provozují aplikace postavené na jazykových modelech a potřebují snížit odezvu i náklady. Z hlediska energetické účinnosti jde o zajímavou alternativu, zejména ve chvíli, kdy jsou datová centra pod tlakem zvyšující se poptávky i ESG požadavků.

LPU tak může v blízké budoucnosti změnit způsob, jakým přistupujeme k AI akceleraci. Ne snahou vše urychlit silnějšími GPU, ale návrhem na míru. Pokud se tento přístup osvědčí, může být Groq jen první vlaštovkou nového trendu.

Groq LPU ukazuje, že existují i jiné cesty, jak zvýšit výkon a efektivitu AI systémů. Jejich čip je rychlý, úsporný, stabilní a specializovaný přesně na to, co dnes firmy od jazykových modelů očekávají: konzistentní a okamžité odpovědi.

O společnosti Groq

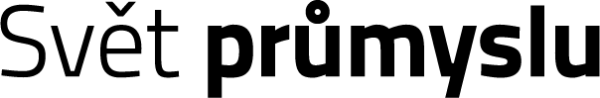

- Společnost Groq, startup zabývající se čipy pro umělou inteligenci, vyvinula speciální hardware pro umělou inteligenci s názvem „Language Processing Unit“ (LPU), který má zvýšit rychlost zpracování jazykových modelů umělé inteligence. Tyto LPU dokáží zpracovat až 500 tokenů za sekundu.

- „GroqChip“, první čip svého druhu v kategorii systémů LPU, je založen na „architektuře tenzorového streamování“ navržené pro vysoký výkon a efektivitu.

- LPU jsou kompatibilní s populárními frameworky strojového učení a mohly by být alternativou k populárním čipům Nvidia, ale zpočátku pouze pro fázi inference, tj. aplikaci plně trénovaných modelů umělé inteligence.

Zdroj: přepracovaná TZ Groq